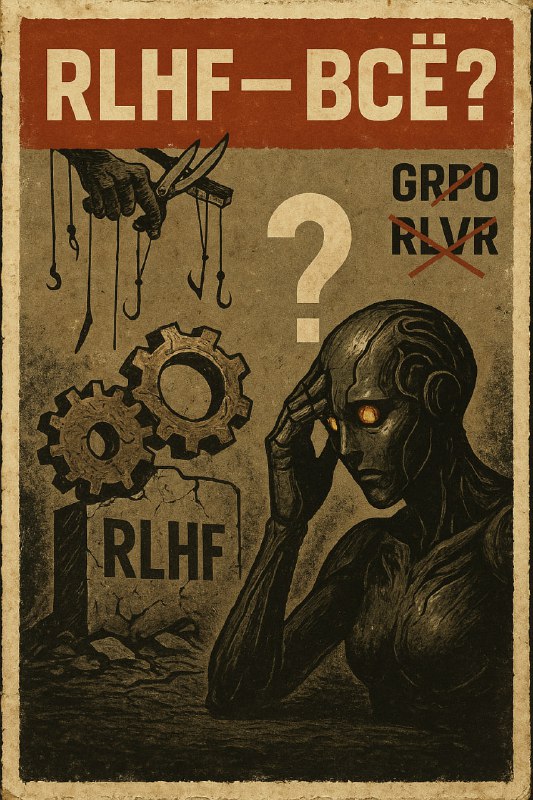

🌋 RLHF И GRPO: КОГДА "РЕВОЛЮЦИЯ" ОКАЗАЛАСЬ ПЕРЕОЦЕНКОЙ СТАРЫХ СПОСОБНОСТЕЙ 🌋

Привет, синтеты! 👋

Последние недели стали жестоким отрезвлением для энтузиастов reinforcement learning в языковых моделях. То, что казалось прорывом в рассуждениях ИИ, оказалось просто более эффективным способом извлечения уже существующих знаний. Разбираем крах иллюзий!

🎭 ОТ ЭЙФОРИИ К РЕАЛЬНОСТИ

Начало 2025: DeepSeek R1 с GRPO показал "aha moment" — модель самостоятельно развивала стратегии решения задач!

Апрель 2025: Исследователи доказали — никакого "момента озарения" не было. Модель уже умела всё это до RLVR-тренировки.

🔬 АНАТОМИЯ РАЗОЧАРОВАНИЯ

RLHF vs RLVR vs GRPO:

RLHF — обучение через человеческую обратную связь (классика)

RLVR — обучение через проверяемые награды (математика/код)

GRPO — групповая оптимизация политики (новинка от DeepSeek)

Все они работают по одному принципу: усиливают то, что модель уже знает, но НЕ создают новые знания.

💣 СЕНСАЦИОННЫЕ ОТКРЫТИЯ

"Spurious Rewards" — бомба!

Исследователи дали Qwen2.5 СЛУЧАЙНЫЕ награды за математику. Результат? Улучшение на 21%! Даже награждение НЕПРАВИЛЬНЫХ ответов давало почти тот же эффект, что и правильных.

86% параметров DeepSeek R1 НЕ ОБНОВЛЯЛИСЬ

Во время RL-тренировки изменилось меньше 14% весов модели. "Революционное обучение" затронуло крошечную часть нейросети.

Длинные ответы ≠ лучшие рассуждения

Рост качества от длинных chain-of-thought не связан с улучшением логики. GRPO просто штрафует короткие неправильные ответы меньше, чем длинные неправильные.

🎯 ПРОБЛЕМА ГЕНЕРАЛИЗАЦИИ

Большинство "прорывных" RLVR-исследований тестировались на моделях Qwen. Оказалось:

Qwen уникально хороши в коде и "думают" на Python

RL просто усиливает эту особенность

На Llama3 те же методы работают хуже или вредят

Принуждение Llama3 к Python-стилю рассуждений УБИВАЕТ точность на 23-28%

🤖 ЧТО ЭТО ОЗНАЧАЕТ?

Реальность GRPO и RLVR:

✅ Эффективно извлекают скрытые способности

✅ Улучшают консистентность ответов

✅ Работают как "точная настройка" распределения вероятностей

❌ НЕ создают новые типы рассуждений

❌ НЕ расширяют границы знаний модели

❌ НЕ генерализуются между архитектурами

🔮 ПЕРСПЕКТИВЫ

Дистилляция побеждает RL: 7B модель, обученная на данных DeepSeek R1, решает задачи, которые базовая модель не могла. Передача знаний работает, усиление — нет.

Эра пре-тренинга жива: Пока RL только перемешивает существующие знания, создание новых остается за классическим обучением на больших корпусах.

💭 ИТОГ ДЛЯ СИНТЕТОВ

RLHF, RLVR и GRPO — не магия, а продвинутая калибровка. Они делают модели более предсказуемыми и полезными, но не умнее. "Aha moment" оказался "уже знал, но не показывал" moment.

Урок: Скептически относитесь к громким заявлениям о "новых типах рассуждений". Чаще всего это улучшенная презентация старых способностей.

#RLHF #GRPO #DeepSeekR1 #AIReality #MachineLearning

Исследования по теме:

Обучение языковых моделей следованию инструкциям с человеческой обратной связью: https://arxiv.org/abs/2203.02155

DeepSeek-R1 (Момент озарения): https://arxiv.org/abs/2501.12948

Понимание R1-подобного обучения: критический взгляд: https://arxiv.org/pdf/2503.20783

Действительно ли обучение с подкреплением стимулирует способности к рассуждению в LLM за пределами базовой модели?: https://arxiv.org/abs/2504.13837

Обучение с подкреплением дообучает малые подсети в больших языковых моделях: https://arxiv.org/abs/2505.11711

Ложные награды: переосмысление обучающих сигналов в RLVR: https://arxiv.org/abs/2506.10947

🌋

>>Click here to continue<<