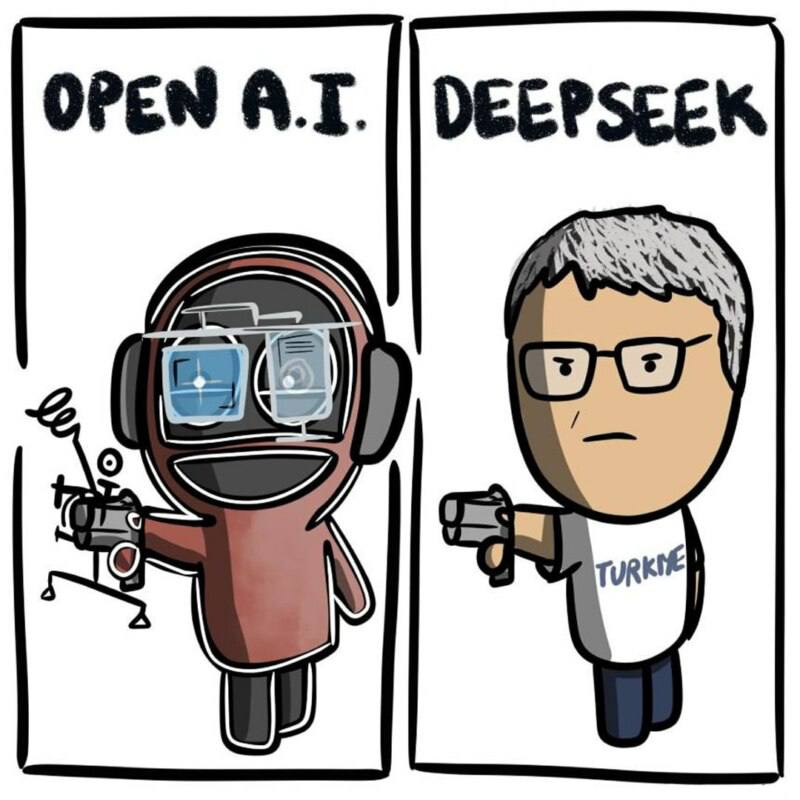

Топовая новость прошедшей недели — релиз китайской нейросети DeepSeek, взбудораживший сферу ИИ. Чтобы узнать мнение эксперта, читайте ниже

7 февраля приглашаем присоединиться к онлайн-марафону на трендовую тему «ИИ да беспилотники»

Что будет?

10 часов марафона

20 экспертов

Онлайн-включения из 18 Точек кипения из 16 городов

Эксперт в студии Точки кипения — Новосибирск:

Не пропустите выступление Ивана с 12:30 до 13:00 по Новосибирску.

Читайте комментарии Ивана по последней новости из мира нейросетей

Модель DeepSeek (по их собственным заявлениям) дешевле: 6 млн. долларов против десятков миллионов у OpenAI. Некоторые думают, что под «дешевизной» скрывается использование нейросети «за копейки», а не как у OpenAI или GigaChat. В случае DeepSeek R1 нужно понимать не низкую стоимость не эксплуатации, а создания и обучения такой модели. На самом деле DeepSeek R1 — дорогая модель, потому что она умеет думать. Прежде чем дать окончательный ответ, модель генерирует большое количество промежуточных рассуждений, рассматривая поставленную перед ней задачу с разных сторон. В отличии от других нейросетевых моделей языка DeepSeek умеет хорошо это делать, потому что её специально обучали для этого. Чем больше слов генерирует модель при запросе пользователя, тем дороже её эксплуатация, так как нужно сделать больше вычислительных вызовов. Поэтому любые «рассуждающие» модели (не только DeepSeek R1, но и, к примеру, O1 от OpenAI) — очень дорогие. У них весьма узкая сфера применения — решение достаточно сложных аналитических задач уровня «старшекурсника хорошего университета», если можно провести такую аналогию. Для большинства типовых задач: ответы на вопросы по документам, категоризацию и классификацию текстов, копирайтинг, можно использовать более простые коммерческие и открытые модели, такие как GPT4o-mini, Gigachat, Qwen 2.5 и др.

Модель есть в открытом доступе, а не «за закрытыми дверями» коммерческой тайны. В плане открытого доступа команда DeepSeek сделала реальную революцию! Впервые нейросеть подобного уровня оказалась в свободном доступе. Движение за открытый доступ к программному коду, данным и моделям существует уже давно. Многие компании выкладывают часть своих разработок в открытый доступ (в том числе и наш российский Сбер, за что я его весьма уважаю). Это стимулирует развитие научного сообщества. Но в открытый доступ выкладываются более простые разработки корпораций, а самые лучшие используются в коммерческих целях.

Работа нейросети потребует серьёзных вложений в аппаратное обеспечение, но это могут быть разовые затраты, так как исследователи и разработчики могут воспользоваться техникой «дистилляции». Это тот вариант работы, когда большая нейросеть обучает маленькую, и уже маленькая отправляется в общее пользование. Такой метод позволяет сэкономить на разметчиках данных, а также сделать маленькую нейросеть умнее. Я считаю, что такой шаг со стороны DeepSeek, как выкладывание R1 в открытый доступ, здорово ускорит прогресс в сфере ИИ и даже приблизит человечество к новому общественно-экономическому укладу.

А мы вас ждём:

#анонс

>>Click here to continue<<